DTM最大の課題に「ボーカルをどうするか」という物があります。

やはりパソコンで音楽を作るDTMにとってボーカルというのは技術的にもなかなか難しいものだったのです。

自分で歌うとか、誰かに歌ってもらうしかボーカルをつける方法はなく、DTMユーザーは泣く泣くインストの曲を作るしかありませんでした。

まあ、インスト好きな僕はこのおかげでインストが流行ったのは嬉しかったんですが。

しかしですね、やっぱりボーカルが入ると楽曲の質も上がる、一般受けする、さらには様々なコンペに提案できるなどと利点もたくさんあります。

そしてDTM界に革命が起きます。VOCALOIDの誕生です。

DTMでボーカルが作成できる、そしてキャラクターは可愛いなどと様々な理由でアッという間に流行ります。

僕も発売された当時は驚いたものだ。

僕がVOCALOIDをやらない理由

僕はソフトウェアオタクですからVOCALOIDはもちろん買いました。今も新しいものが出ると買っています。

しかし、いわゆるボカロ曲は全然作りません。たまにシンガーソングライターさんへの作曲や編曲の時の仮歌としてボーカロイドを使う事もありますが、ほんとたまにです。

しかし、とあるボカロP(VOCALOIDの曲を作る人をこう呼ぶ)がウチに遊びに来た時に僕の音楽用のパソコンを見てよだれを垂らしたのです。なんてったって現行発売されているVOCALOIDのライブラリーのほとんどがインストールされているわけですから。

そりゃあ僕だって一応はお金貰ってるから端くれとはいえプロですし、ソフトウェアエンジニアもやってるので音楽系のソフトウェアなら大体は経費で落ちます。そもそも僕がくそ忙しいなか全然儲からないソフト開発を続けるのはこの経費でソフト買うのが目当てみたいなところもありますから。

ちなみにソフトシンセやエフェクトなんかも大体は入ってますからね。「この環境でなぜ曲を作らない・・。」とその友人には言われました。時間がねぇんだよ。

で、まあなぜ僕はDTM界の巨大派閥「VOCALOID」をあまりやらないのかというといろんな理由があります。

①めんどくさい

ボーカロイドは打ち込むのがめちゃくちゃ大変です。音程歌詞発音、ビブラートやその他いろいろと1音1音に時間がかかりすぎます。

そもそもVOCALOID自体が人間のボーカリストの代替品として活用されているわけなのですから、歌録りを依頼できる信頼できるボーカリストがいるのであれば依頼した方が全然早いです。

②いわゆるオタク文化だから

僕自体はオタク文化は肯定的ですが、悲しいかな毛嫌いする人も多いのが現実です。

僕みたいに商業的に音楽をやっていると「オタクキモイ!」とされてしまうのは結構なデメリットです。

正直、ものすごくいい曲でも「ボカロだから聞かない!」という人は多いです。

VOCALOIDが流行った理由にキャラクターが可愛いからと書きましたが、ある一定のレベルから抜け出せないのはこのキャラクターが原因でしょう。DTMマガジンもストイックなニッチな雑誌でしたが、VOCALOIDの出現からなんとなく買いにくい雑誌となりましたしね。

ちなみにVOCALOIDの一号機、初音ミクはYAMAHAのDX7という往年の銘記シンセサイザーがモデルです。

まさかこんな渋いシンセが美少女キャラになるとは思いもしなかった。

③ボカロ>僕になってしまう

3つ目にはボカロ曲を作ると、どうしてもボカロ>僕になってしまう点です。

ボカロ曲で一番注目されるのがそのキャラクターというか歌声です。その次に作曲者。

あとボカロ曲はジャンルが「ボカロ」になってしまうんです。上でも言った通り「ボカロだから聞かない」と言われてしまう原因ですね。

相当な数のライブラリ(キャラクター、歌声の種類)があるとはいえボカロを使うことによって一つのオリジナリティが奪われてしまうんです。これは僕がボカロを使わない最大の理由かもしれません。

④機械っぽさがどうしても抜けない

こればっかりは仕方がないですが、機械っぽさがやはりどうしても残ってしまいます。

技術などである程度はカバーできるみたいですが、それでも「人間の歌声と間違える」ことはありえないでしょう。

オリジナリティと利便さの共存へ

ボカロを使うとオリジナリティの一つが奪われてしまうと書きました。

しかし、やはりボーカルというのは音楽では最もと言っていいほど重要なコンテンツです。

ボーカリストの壁、レコーディングの壁を取り払えるVOCALOIDはやはり魅力的。

どうにかならんものかとふと考えました

自分のオリジナルのライブラリを作ればいいのではないか、と。

たとえば自分自身の声を使ったボーカロイドのようなものを作ればオリジナリティが奪われることはありません。

なんてったって僕なんですから。

しかし現行のYAMAHA製のVOCALOIDのライブラリを作るにはYAMAHAのライセンスを取る必要があるっぽいです。実質「不可能」だそうです。

ならばVOCALOID自体作ってやろう、ワシの技術力をなめるんじゃないと作り始めました。

そして完成したのが試作品1号です。

この試作品1号はボコーダーとシンセサイザーの技術を応用したもので、単純な原理としては

「あ」から「ん」までの音声を準備。それを選ばれた音程へピッチ補正し出力するという単純なもの。

これで一応は自分の声で歌を打ち込み出来るようになりました。

しかし、課題が残ります。それが機械っぽさがハンパじゃないです。

いっそのことクラフトワーク的に使えば使えそうですが、モロに機械でした。

それを改善すべくその機械っぽさの原因を考えました。

1ピッチ補正による不自然

2歌詞の音と音の途切れ

3音程の途切れ

1ピッチ補正による不自然 はやはりある程度は仕方ないと思ってはいました。

どういう事かというと原音がAの音だとして、このAから遠ざかれば遠ざかるほど違和感が生じてしまいます。

これの改善方法として「原音の多音階化」を思いつきました。

つまり、録音した原音をAやC、Fなど多くの音階で取りピッチ補正をしてもばれない程度にすればいいわけです。

Aを鳴らしたいときは録音したAのサンプリング、Gを鳴らしたいときにはAのサンプリングをピッチ補正。

Cを鳴らしたいときは録音したAのサンプリング、Dを鳴らしたいときにはAのサンプリングだと離れていて違和感が出てしまうのでCのサンプリングをピッチ補正したものを使う、という方法です。

この結果割と機械っぽさは改善されました。いわゆる「ケロケロ声」が無くなったのですが、まだ2歌詞の音と音の途切れ

3音程の途切れの課題が残ります。

2歌詞の音と音の途切れはこの試作品1号ではたとえば「いま」と歌う時、「い」「ま」と2つの音声を使います。

そうするとどうしても「い」と「ま」の間に違和感が生じてしまうわけですね。

人間の歌声というのは流れがあります。「いま」と歌う時に「い!」「ま!」と歌ってるわけではなく「い」と「ま」の間にも余韻というか微妙に音があるんですね。

話し声ならともかく歌声となるとそれは結構重要で、「い」と「ま」の間にほんのちょっとでもスキマがあると不自然になってしまいます。

これを改善するためにどうしたらいいかと考えていたら、DJの曲繋ぎを見て思いつきました。

音楽の1曲と1曲繋ぐときに「クロスフェード」という方法を取ることがあります。前の曲を徐々に小さく、次の曲を徐々に大きくする方法です。これを応用します。

そしてさらに「母音のクロスフェード」を使います。

今までは「いま」と歌わせるときには「い」と「ま」の音声を使ってましたが、これを「い→a」「i→ま」という音声を使うわけです。

録音している音声は50音(プラス濁音など)ですが、それぞれ母音へと移動する音声を準備します。

それをあえて母音部分を少し重ね「い(→a→)ま」と発音させます。

3音で考えるともっと分かりやすいです。「さいた」と歌いたいとします。

通常だと「さ」と「い」と「た」の音声を使いますが、これを「さい」「あい」「いた」の音声を使いそれぞれ「あ」と「い」を重ねてクロスフェードします。

そうすることによって音と音の間の余韻を再現することが出来たのです。

3音程の途切れはこんなもん簡単です。

語尾や言葉の前をすこーしだけピッチを上げたり下げたりするだけです。画像処理のアンチエイリアスのようなもんです。

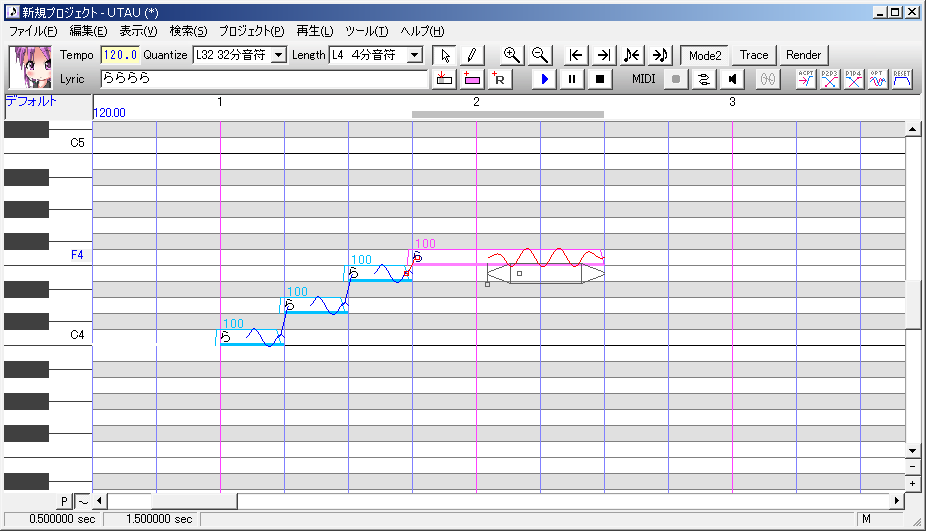

こうして完成した自作VOCALOID試作品2号

このようにして完成した試作品2号。マジで億万長者いけるんじゃねって思ったほどの出来栄えでした。

例のボカロPにこの試作品2号を見せ、自慢していたところですね。

「それUTAUで出来るよ。」

という理解のできない言葉が出てきました。

UTAU自体は知ってました。

どうせVOCALOIDも買えない貧乏人が使うフリーウェアだろ、そうだろ的に思っていました。完全に舐めてました。すいません。

その友人が言うには「オリジナルライブラリの作成」「クロスフェード」「音程のピッチ補正」すべて出来るぞ、とのことです。

ソフトウェアから作った僕は一体・・・。と落ち込みましたが、せっかくなのでUTAUを調べてみることにしたんです。

そこで一つに衝撃的な動画に出会いました。

人間の歌声と間違うほどの自然さです。驚きました。

この動画を見て「UTAUのライブラリを作ろう」と決めました。

自分の声を録音し、オリジナルライブラリを作ればかなりのものが作れるはずです。

そしてUTAUライブラリの制作が始まったわけです。

続く

コメント